Los ataques contra los sistemas de aprendizaje automático ya están aquí

Actualmente la mayoría de ataques dirigidos contra los sistemas de inteligencia artificial (IA) se centran en manipularlos. Así, por ejemplo, en los sistemas de recomendación se trata de favorecer un contenido específico, en vez del que le correspondería de forma legítima. Ahora los ciberdelincuentes están aprovechando este tipo de ataques utilizando el aprendizaje automático (ML) y han sido descritos en una matriz de amenazas.

Según Microsoft, los ataques a los sistemas de aprendizaje automático (ML) van aumentado poco a poco. Además, el MITRE comenta que, en los últimos tres años, empresas importantes como Microsoft, Google, Amazon y Tesla han visto sus sistemas de ML comprometidos. En este sentido, la mayoría de las organizaciones no poseen las soluciones adecuadas para proteger sus sistemas de aprendizaje automático y están buscando orientación en cómo hacerlo.

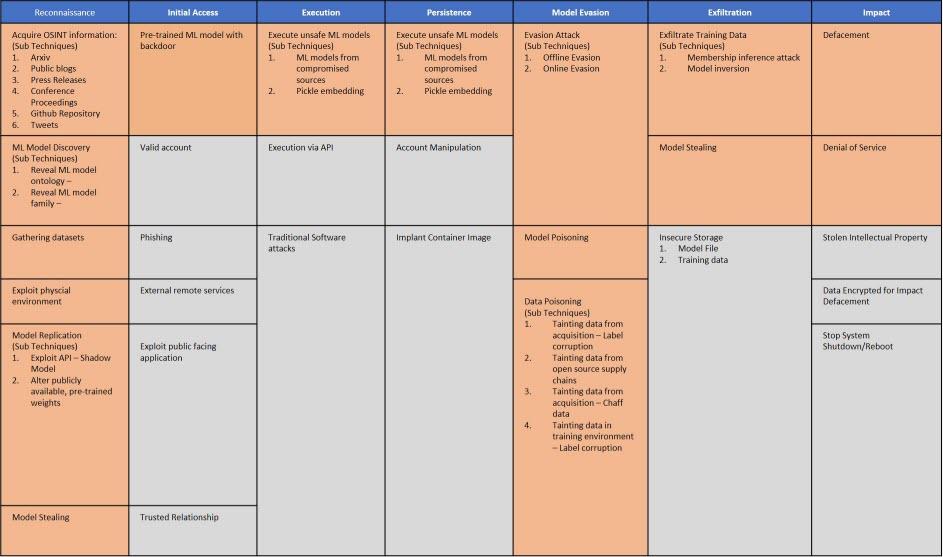

Así, los expertos de Microsoft, MITRE, IBM, NVIDIA, la Universidad de Toronto, el Berryville Institute of Machine Learning junto con otras empresas y organizaciones, han creado la primera versión de Adversarial ML Threat Matrix. Su objetivo es crear una matriz de amenazas que ayude a los analistas de seguridad a detectar y responder ante este tipo de ataques.

La inteligencia artificial como método para realizar ataques

La inteligencia artificial es un recurso cada vez más utilizado para infectar equipos, robar información y comprometer la seguridad. Una de las técnicas en las que podemos utilizar la inteligencia artificial y el aprendizaje automático es para el envenenamiento de datos.

Este ataque está pensado para manipular un conjunto de datos de entrenamiento para controlar el comportamiento de predicción. El objetivo es que funcione incorrectamente y que obedezca las premisas del atacante. Así, podría clasificar los correos de spam como contenido apropiado y llegarán a nuestra bandeja de entrada.

El aprendizaje automático y la seguridad

El aprendizaje automático, que viene del ML (Machine Learning), es una rama de la inteligencia artificial cuyo objetivo es desarrollar técnicas que permitan que los ordenadores aprendan de manera autónoma. Los investigadores del aprendizaje de máquinas, buscan algoritmos para convertir muestras de datos en programas de ordenador, sin tener que escribirlos. Así, los programas resultantes deben ser capaces de generalizar comportamientos, hacer predicciones, tomar decisiones o clasificar cosas con precisión.

Mikel Rodríguez, un investigador de aprendizaje automático en MITRE ha comentado que ahora estamos en la misma etapa con la IA que con Internet a finales de la década de 1980. En esa época internet estaba diseñado para trabajar, y no estaba pensado para construir en su seguridad para mitigar posibles ataques.

No obstante, se puede aprender de esa equivocación, y por ese motivo se ha creado la Matriz de amenazas de Adversarial ML. Lo que se pretende conseguir, es que esta matriz ayude a pensar de manera integral, y estimulará una mejor comunicación. Así, se pretende fomentar la colaboración entre las organizaciones al brindar un lenguaje común de las diferentes vulnerabilidades.

Qué nos aporta la matriz de amenazas de ML adversario

Gracias a esta matriz de amenazas, los administradores de seguridad pueden trabajar con modelos basados en incidentes reales, y que emulan el comportamiento que tiene un adversario que utiliza el aprendizaje automático. Para crear la matriz, usaron como plantilla ATT & CK debido a que los analistas de seguridad están familiarizados con la utilización de este tipo de matriz.

En la matriz de amenazas tenemos las distintas fases del ataque como son: reconocimiento, acceso inicial, ejecución, persistencia, evasión, exfiltración e impacto. De este modo, en la segunda etapa de acceso inicial, nos encontramos con el ataque de phising del que tanto se habla. Si queréis consultar más datos sobre la descripción de fases de Adversarial ML Matrix aquí tenéis este link. Puedes ver algunos cursos de Aprendizaje Automatizado.

Un dato importante a tener cuenta, es que la matriz de amenazas no es un marco de priorización de riesgos, y sólo recopila las técnicas conocidas. Además, se ha demostrado que los ataques se pueden asignar a la matriz. Por último, la matriz de amenazas se actualizará de forma periódica a medida que se reciban comentarios de la comunidad de aprendizaje automático de seguridad y adversarios. También quieren fomentar que los colaboradores señalen nuevas técnicas, propongan las mejores prácticas y compartan ejemplos de ataques con éxito.